La memoria GPU condivisa è un tipo di memoria virtuale che viene generalmente utilizzata quando la GPU esaurisce la memoria video dedicata. La memoria GPU condivisa, quindi, non è la stessa dedicato Memoria GPU. C’è una grande differenza tra questi due tipi di VRAM.

La memoria dedicata rappresenta la quantità di VRAM fisica posseduta da una GPU, mentre la memoria GPU condivisa rappresenta a virtuale quantità prelevata dalla RAM del sistema. I moderni sistemi operativi svolgono un ottimo lavoro quando si tratta di ottimizzare l’utilizzo della memoria video condivisa.

Quando disponi di una GPU integrata o dedicata, il tuo sistema operativo occuperà fino alla metà della RAM e la utilizzerà come condiviso Memoria GPU. Ciò, a chi non lo sapesse, potrebbe sembrare strano, ma in realtà c’è una spiegazione molto logica dietro tutto.

Perché i sistemi operativi utilizzano la RAM come fonte di memoria per la tua GPU quando ce n’è molta di più disponibile su dischi rigidi e SSD? Il motivo è piuttosto semplice: La RAM lo è tanto più veloce di qualsiasi SSD o HDD disponibile.

Differenza tra memoria GPU dedicata e condivisa

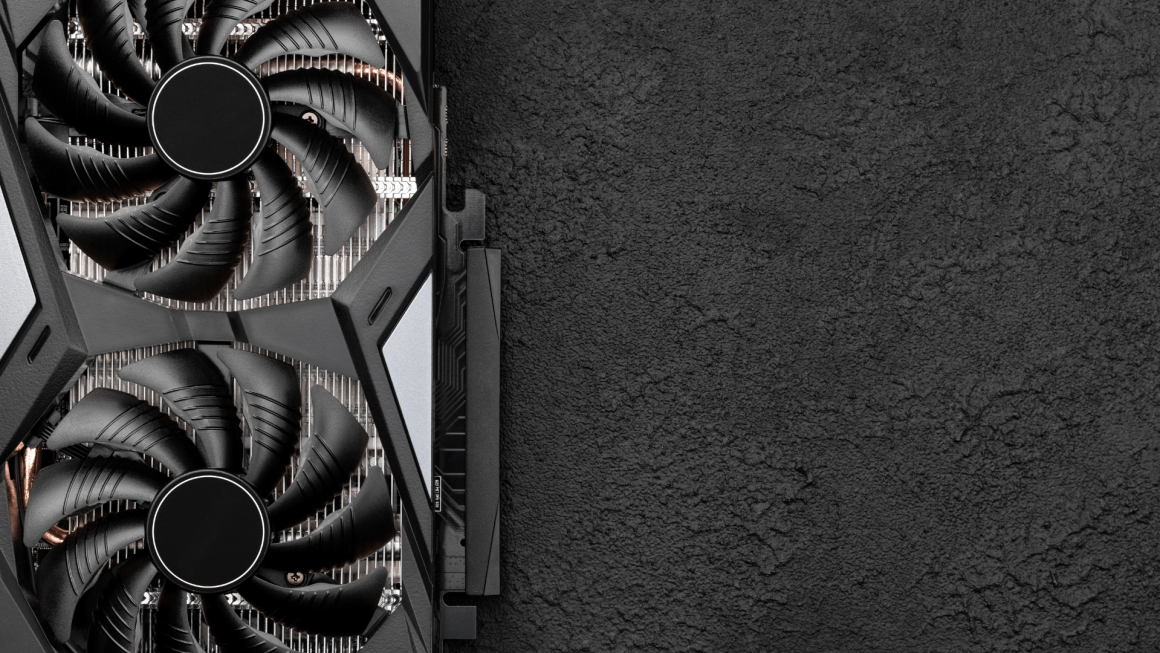

Dedicato: La memoria GPU è la memoria fisica situata su una scheda grafica discreta stessa. Generalmente si tratta di moduli di memoria ad alta velocità (GDDR / HBM) posizionati vicino al chip principale della GPU, che viene utilizzato per il rendering di software, applicazioni e giochi (tra le altre cose).

Condiviso: La memoria GPU viene “proveniente” prelevata dalla RAM di sistema – non è fisica, ma virtuale – fondamentalmente solo un’allocazione o un’area riservata sulla RAM di sistema; questa memoria può quindi essere utilizzata come VRAM (Video-RAM) una volta che il tuo dedicato La memoria della GPU (se presente) è piena.

Se hai una iGPU (una GPU integrata nella tua CPU), questa iGPU non ha alcun tipo di VRAM dedicata. Pertanto dovrà utilizzare la RAM di sistema.

Tuo il sistema dedicherà fino al 50% della RAM fisica alla memoria GPU condivisa, indipendentemente dal fatto che tu abbia una GPU integrata o dedicata.

Come puoi vedere nell’immagine qui sotto, il mio PC ha una Nvidia GTX 1660 con 6 GB di VRAM (memoria GPU dedicata) e poiché ho 16 GB di RAM di sistema, 8 di questi sono allocati per essere utilizzati per la “Memoria GPU condivisa” (metà della RAM del mio sistema).

Dovresti diminuire o aumentare la memoria GPU condivisa?

Sorge una domanda importante: dovresti armeggiare con queste impostazioni? Beh, dipende davvero dalla tua configurazione.

Se hai una GPU dedicata, lasciare le cose come sono probabilmente sarebbe la cosa migliore. A seconda della scheda grafica e della capacità VRAM, la memoria GPU condivisa potrebbe non essere utilizzata affatto! Se la situazione diventa critica e il tuo sistema operativo ricorrere a questa peculiare procedura, non ne causerà alcuno aggiuntivo problemi di prestazione a parte picchi e cali di frame nel momento stesso in cui il buffer VRAM della tua GPU è pieno.

Se tu hai una GPU dedicata ma piuttosto un integrato (come l’Intel UHD Graphics 730, ad esempio), si dovrebbe comunque evitare di armeggiare con le impostazioni di memoria della GPU condivisa.

I moderni sistemi operativi svolgono un ottimo lavoro di gestione e allocazione della memoria, quindi è meglio lasciarli fare.

Poiché il 50% della RAM di sistema può già essere utilizzato dalla (i)GPU, è improbabile che il carico di lavoro necessiti di più VRAM (memoria condivisa) senza che sia necessaria anche la RAM per funzionare. Se avessi un’applicazione semplice che utilizza solo molte risorse della GPU ma non della CPU, potresti notare un impatto sulle prestazioni quando allochi più memoria GPU condivisa da utilizzare.

Non c’è davvero bisogno che tu regoli manualmente nulla, anche se se ti pruriscono le dita, tu Potere fallo regolando le impostazioni della memoria video nel BIOS o, nel caso in cui disponi di un’APU Intel o AMD, apportando le modifiche desiderate nell’editor del registro di Windows.

FAQ

La memoria GPU condivisa è più lenta della memoria GPU dedicata (VRAM)?

SÌ. Poiché la memoria condivisa è essenzialmente RAM, se una GPU deve ricorrere all’utilizzo della RAM del sistema per i suoi calcoli, subirà un calo delle prestazioni.

I moduli VRAM dedicati sono vicini al chip principale della GPU ed è possibile accedervi molto più rapidamente rispetto al passaggio attraverso il bus PCIe attraverso la scheda madre per trovare qualcosa nella RAM di sistema.

A cosa serve la memoria GPU condivisa?

La memoria GPU condivisa viene presa in prestito dalla quantità totale di RAM disponibile e viene utilizzata quando il sistema esaurisce la memoria GPU dedicata.

Il sistema operativo attinge alla RAM perché è la cosa migliore in termini di prestazioni; La RAM è molto più veloce di qualsiasi SSD sul mercato, e sicuramente rimarrà così per il prossimo futuro.

Come modificare il valore della memoria GPU condivisa in Windows?

Modificare la quantità di memoria GPU condivisa del tuo sistema non è così semplice come si potrebbe pensare.

Dovrai armeggiare con le impostazioni del BIOS se desideri regolare o disattivare la funzionalità di memoria GPU condivisa.

Non è consigliabile, tuttavia, poiché apportare questo tipo di modifiche non migliorerà le prestazioni del sistema nella maggior parte dei carichi di lavoro.

Qual è la differenza tra memoria GPU totale, dedicata e condivisa?

La memoria video dedicata è la quantità di memoria fisica sulla tua GPU. La memoria GPU condivisa è la quantità di virtuale memoria che verrà utilizzata nel caso in cui la memoria video dedicata si esaurisca. Solitamente corrisponde al 50% della RAM disponibile. Quando questi due pool di memoria vengono combinati, ottieni la quantità totale.